Scorecard

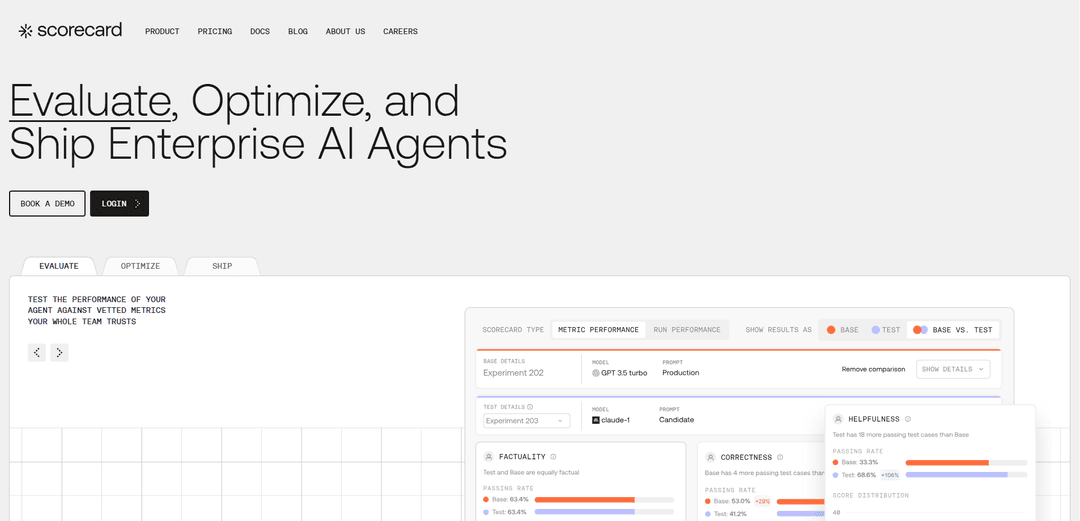

Scorecard là một nền tảng đánh giá AI giúp các nhóm xây dựng, kiểm tra và triển khai các ứng dụng LLM đáng tin cậy thông qua kiểm tra có hệ thống, đánh giá liên tục và giám sát hiệu suất.

https://scorecard.io/?ref=producthunt&utm_source=aipure

Thông tin Sản phẩm

Đã cập nhật:Nov 9, 2025

Scorecard là gì

Scorecard là một nền tảng được thiết kế để hỗ trợ các nhóm sản phẩm và kỹ sư trong việc phát triển và triển khai các ứng dụng Mô hình ngôn ngữ lớn (LLM) một cách tự tin. Được thành lập vào năm 2024 và có trụ sở chính tại San Francisco, công ty gần đây đã đảm bảo được 3,75 triệu đô la tài trợ ban đầu. Nền tảng này giải quyết thách thức về tính không thể đoán trước của AI bằng cách cung cấp các công cụ toàn diện để kiểm tra, đánh giá và giám sát hiệu suất, cho phép các nhóm xuất xưởng các sản phẩm AI nhanh hơn và đáng tin cậy hơn.

Các Tính năng Chính của Scorecard

Scorecard là một nền tảng đánh giá toàn diện được thiết kế để kiểm tra, xác thực và triển khai các tác nhân AI và ứng dụng LLM. Nó cung cấp các công cụ để đánh giá liên tục, quản lý lời nhắc, tạo số liệu và theo dõi hiệu suất trong suốt vòng đời phát triển AI. Nền tảng này cung cấp các tính năng như thử nghiệm A/B, gắn nhãn thủ công để xác thực ground truth, tích hợp SDK và môi trường playground để thử nghiệm nhanh chóng, giúp các nhóm xuất xưởng các sản phẩm AI nhanh hơn và tự tin hơn.

Đánh giá hiệu suất AI: Cung cấp khả năng giám sát và đánh giá liên tục các tác nhân AI với thư viện số liệu đã được xác thực và khả năng tạo số liệu tùy chỉnh

Hệ thống quản lý lời nhắc: Cho phép kiểm soát phiên bản và lưu trữ các lời nhắc với khả năng theo dõi lịch sử hiệu suất và các tính năng cộng tác nhóm

Testing Playground: Cung cấp một môi trường tương tác để thử nghiệm nhanh chóng và so sánh các phiên bản hệ thống AI khác nhau bằng cách sử dụng các yêu cầu thực tế

Tích hợp sản xuất: Bao gồm hỗ trợ SDK và khả năng theo dõi để giám sát và gỡ lỗi các hệ thống AI trong môi trường sản xuất

Các Trường hợp Sử dụng của Scorecard

Phát triển ứng dụng LLM: Các nhóm phát triển ứng dụng mô hình ngôn ngữ có thể kiểm tra, xác thực và tối ưu hóa các mô hình của họ trước khi triển khai

Triển khai AI doanh nghiệp: Các tổ chức lớn có thể đảm bảo kiểm soát chất lượng và tuân thủ khi triển khai các giải pháp AI trên các phòng ban khác nhau

Tối ưu hóa hệ thống RAG: Các nhóm có thể đánh giá và cải thiện hệ thống Tạo tăng cường truy xuất của họ bằng cách kiểm tra liên tục và theo dõi hiệu suất

Phát triển Chatbot: Các nhà phát triển có thể kiểm tra và tinh chỉnh các phản hồi của chatbot, đảm bảo các tương tác nhất quán và chính xác với người dùng

Ưu điểm

Các công cụ đánh giá toàn diện với các số liệu đã được xác thực

Dễ dàng tích hợp với các quy trình làm việc hiện có thông qua SDK

Khả năng giám sát và phản hồi theo thời gian thực

Nhược điểm

Có thể yêu cầu thời gian ngừng hoạt động bảo trì để cập nhật nền tảng

Đường cong học tập cho các nhóm mới sử dụng các công cụ đánh giá AI

Cách Sử dụng Scorecard

Tạo tài khoản Scorecard: Đăng ký tài khoản Scorecard và lấy khóa API của bạn. Đặt khóa API làm biến môi trường để xác thực.

Tạo một dự án: Tạo một dự án mới trong Scorecard nơi các thử nghiệm và lần chạy của bạn sẽ được lưu trữ. Ghi lại ID dự án để sử dụng sau này.

Tạo một bộ thử nghiệm: Tạo một bộ thử nghiệm trong dự án của bạn và thêm các trường hợp thử nghiệm. Bộ thử nghiệm là một tập hợp các kịch bản thử nghiệm được sử dụng để đánh giá hiệu suất của hệ thống LLM của bạn.

Xác định số liệu: Chọn từ thư viện số liệu đã được xác thực của Scorecard hoặc tạo số liệu tùy chỉnh để đánh giá hệ thống của bạn. Sử dụng phương thức metrics.create() để xác định tiêu chí đánh giá bằng cách sử dụng các mẫu lời nhắc.

Thiết lập hệ thống LLM của bạn: Triển khai hệ thống LLM của bạn bằng cách sử dụng từ điển cho đầu vào và đầu ra theo yêu cầu của giao diện Scorecard.

Chạy đánh giá: Thực hiện các thử nghiệm của bạn bằng cách nhấp vào nút \'Chạy chấm điểm\' trong giao diện người dùng Scorecard hoặc thông qua API để đánh giá hệ thống của bạn bằng các số liệu đã xác định.

Giám sát kết quả: Xem lại kết quả đánh giá trong giao diện người dùng Scorecard để hiểu hiệu suất của hệ thống, xác định các vấn đề và theo dõi các cải tiến.

Đánh giá liên tục: Sử dụng các tính năng ghi nhật ký và theo dõi của Scorecard để theo dõi hiệu suất của hệ thống AI của bạn trong thời gian thực và xác định các lĩnh vực cần cải thiện.

Lặp lại và cải thiện: Dựa trên những hiểu biết sâu sắc thu được, hãy thực hiện các cải tiến cho hệ thống của bạn và lặp lại quy trình kiểm tra để xác thực các thay đổi.

Câu hỏi Thường gặp về Scorecard

Scorecard là một nền tảng đánh giá AI giúp các nhóm kiểm tra, đánh giá và tối ưu hóa các tác nhân AI. Nó cung cấp các công cụ để đánh giá liên tục, quản lý lời nhắc và giám sát hiệu suất của các mô hình AI.

Video Scorecard

Bài viết phổ biến

Các Công Cụ AI Phổ Biến Nhất Năm 2025 | Bản Cập Nhật 2026 từ AIPURE

Feb 10, 2026

Moltbook AI: Mạng xã hội Dành cho AI Thuần túy Đầu tiên của Năm 2026

Feb 5, 2026

ThumbnailCreator: Công cụ AI giải quyết nỗi lo lắng về hình thu nhỏ trên YouTube của bạn (2026)

Jan 16, 2026

Kính thông minh AI 2026: Góc nhìn phần mềm về thị trường AI đeo được

Jan 7, 2026