TrueFoundry AI Gateway

TrueFoundry AI Gateway 是一個企業級控制平面,使組織能夠透過統一的 API 部署、管理和監控 LLM 和 Gen-AI 工作負載,並具有內建的安全性、可觀察性和效能優化功能。

https://www.truefoundry.com/ai-gateway?ref=producthunt&utm_source=aipure

產品資訊

更新時間:2025年12月09日

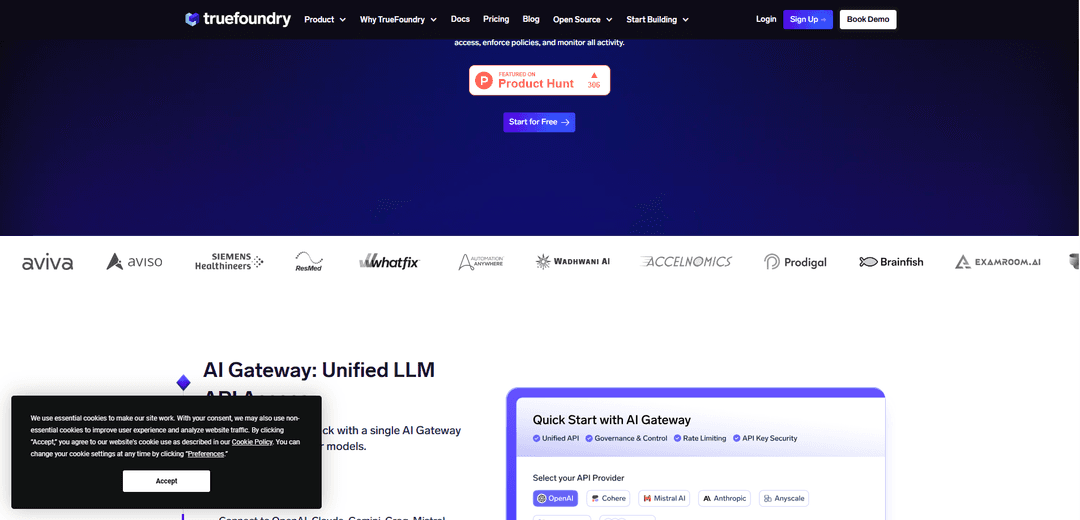

什麼是 TrueFoundry AI Gateway

TrueFoundry AI Gateway 充當一個集中式中間件層,位於應用程序和多個 LLM 提供商之間,充當 AI 模型的翻譯器和流量控制器。它提供了一個單一介面來連接、管理和監控各種 LLM 提供商,如 OpenAI、Claude、Gemini、Groq、Mistral 和 250 多個其他模型。該閘道處理關鍵的基礎設施需求,包括身份驗證、路由、速率限制、可觀察性和治理 - 允許組織在保持安全性和合規性的同時標準化其 AI 運營。

TrueFoundry AI Gateway 的主要功能

TrueFoundry AI Gateway 是一個企業級中介軟體平台,提供對 1000 多個 LLM 的統一存取,並具有全面的安全性、可觀察性和治理功能。它為 API 管理、模型路由、成本追蹤和效能監控提供集中控制,同時支援跨 VPC、本地部署或氣隙環境的部署。該平台使組織能夠透過負載平衡、故障轉移機制和詳細分析等功能來實施護欄、執行合規性政策和優化 AI 運營。

統一模型存取與控制: 單一 API 端點,用於存取 1000 多個 LLM,並在包括 OpenAI、Claude、Gemini 和自訂模型在內的多個供應商之間進行集中金鑰管理、速率限制和 RBAC 控制

全面可觀察性: 即時監控 Token 使用量、延遲、成本和效能指標,並具有詳細的請求級別日誌記錄和追蹤功能,用於除錯和優化

進階安全與合規: 內建 PII 偵測、內容審核和策略執行的護欄,並支援 SOC 2、HIPAA 和 GDPR 合規性要求

高效能架構: 低於 3 毫秒的內部延遲,並能夠在 1 個 vCPU 上處理 350+ RPS,具有智慧負載平衡和自動故障轉移機制

TrueFoundry AI Gateway 的使用案例

企業 AI 治理: 大型組織實施集中控制和監控跨多個團隊和應用程式的 AI 使用情況,同時確保合規性和成本管理

醫療保健 AI 應用: 醫療機構部署具有 HIPAA 合規性、PII 保護和嚴格資料治理要求的 AI 解決方案

多模型生產系統: 在生產中運行多個 AI 模型,需要對其 AI 基礎架構進行統一管理、監控和優化的公司

安全代理開發: 構建需要安全工具整合、提示管理和對各種企業系統的受控存取的 AI 代理的組織

優點

高效能,低延遲和出色的可擴展性

全面的安全性和合規性功能

豐富的可觀察性和監控功能

靈活的部署選項(雲端、本地部署、氣隙)

缺點

對於企業部署,可能需要大量的設定和配置

對於 AI 需求較小的較小組織來說,可能很複雜

如何使用 TrueFoundry AI Gateway

建立 TrueFoundry 帳戶: 註冊一個 TrueFoundry 帳戶,並按照令牌生成說明生成一個個人訪問令牌 (PAT)

獲取閘道配置詳細資訊: 從 TrueFoundry Playground 中的統一程式碼片段中獲取您的 TrueFoundry AI Gateway 端點 URL、基本 URL 和模型名稱

配置 API 客戶端: 透過在您的程式碼中配置 api_key(您的 PAT)和 base_url(閘道 URL)來設定 OpenAI 客戶端以使用 TrueFoundry Gateway

選擇模型提供商: 透過統一的 Gateway API 從可用的模型提供商(如 OpenAI、Anthropic、Gemini、Groq 或 Mistral)中進行選擇

設定存取控制: 透過 Gateway 管理介面為團隊和使用者配置速率限制、預算和 RBAC 策略

實施防護措施: 使用 Gateway 的防護措施配置設定輸入/輸出安全檢查、PII 控制和合規性規則

啟用監控: 透過配置指標、日誌和追蹤來設定可觀察性,以追蹤延遲、令牌使用情況、成本和效能

在 Playground 中測試: 在生產中實施之前,使用互動式 Playground UI 測試不同的模型、提示和配置

部署到生產環境: 將 Gateway 放置在您的生產推理路徑中,並透過它路由即時流量,同時監控效能

優化和擴展: 使用 Gateway 分析來優化成本、提高延遲,並根據使用模式擴展基礎設施

TrueFoundry AI Gateway 常見問題

TrueFoundry AI Gateway 是一個代理層,位於應用程式和 LLM 提供者/MCP 伺服器之間。它通過單個 API 提供對 250 多個 LLM(包括 OpenAI、Claude、Gemini、Groq、Mistral)的統一訪問,集中管理 API 金鑰,實現對 Token 使用情況和效能指標的可觀察性,並執行治理策略。它支援聊天、完成、嵌入和重新排序模型類型,同時確保低於 3 毫秒的內部延遲。