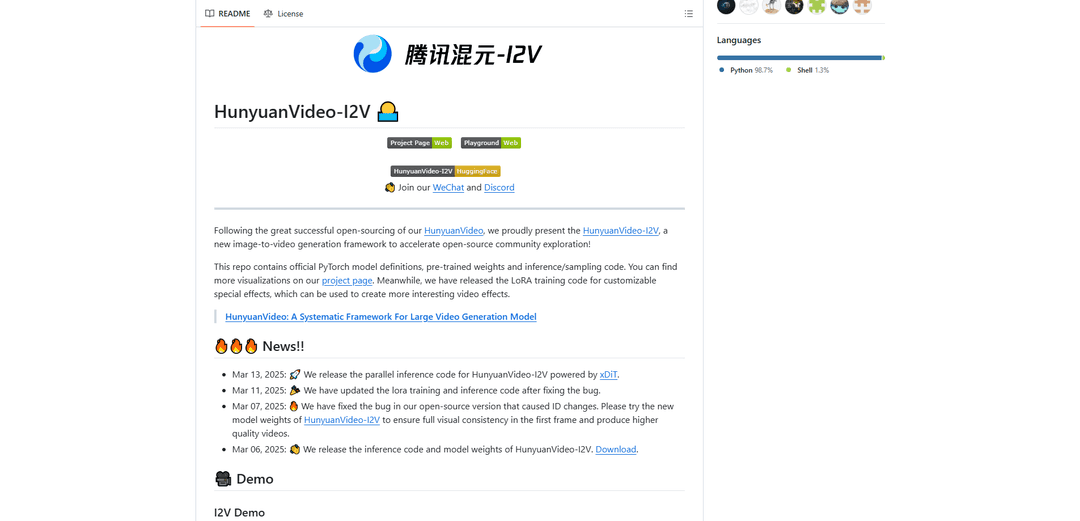

HunyuanVideo-I2V

HunyuanVideo-I2V es un marco de IA de código abierto desarrollado por Tencent que transforma imágenes estáticas en videos dinámicos de alta calidad con efectos de movimiento personalizables y una consistencia visual excepcional.

https://github.com/Tencent/HunyuanVideo-I2V?ref=producthunt&utm_source=aipure

Información del Producto

Actualizado:09/12/2025

¿Qué es HunyuanVideo-I2V?

HunyuanVideo-I2V es un modelo de generación de imagen a video de vanguardia basado en la exitosa base de HunyuanVideo. Lanzado por el Laboratorio Hunyuan de Tencent, representa un avance significativo en la síntesis de video impulsada por IA, capaz de generar videos de hasta 720P de resolución y 129 fotogramas (5 segundos) de duración. El marco está diseñado para cerrar la brecha entre las imágenes estáticas y el contenido de video dinámico, ofreciendo opciones de movimiento tanto de estabilidad como de alta dinámica para adaptarse a diferentes necesidades creativas. Viene con herramientas integrales para la personalización, incluidas las capacidades de entrenamiento LoRA para efectos de video especializados.

Características Principales de HunyuanVideo-I2V

HunyuanVideo-I2V es un marco de código abierto avanzado para la generación de imágenes a video desarrollado por Tencent que transforma imágenes estáticas en videos dinámicos de alta calidad. Utiliza un Modelo de Lenguaje Grande Multimodal pre-entrenado con una arquitectura Decoder-Only, lo que permite una comprensión integral de las entradas de imagen y texto. El marco admite la generación de video de alta resolución de hasta 720P y una duración de video de hasta 129 fotogramas (5 segundos), con opciones para modos de generación de video estables y dinámicos.

Arquitectura Unificada de Imagen y Video: Emplea un diseño Transformer con mecanismo de atención completa que admite la generación unificada de imágenes y videos, lo que permite una integración perfecta de la información de imagen y texto

Control de Movimiento Personalizable: Ofrece un control flexible sobre la dinámica del video a través de configuraciones de estabilidad y parámetros de cambio de flujo, lo que permite a los usuarios generar videos estables o altamente dinámicos

Salida de Alta Resolución: Capaz de generar videos de alta calidad con una resolución de hasta 720P con 129 fotogramas, manteniendo la coherencia visual durante todo el proceso de generación

Soporte de Entrenamiento LoRA: Incluye capacidades de entrenamiento LoRA para efectos especiales personalizables, lo que permite a los usuarios entrenar y aplicar efectos de video específicos a sus generaciones

Casos de Uso de HunyuanVideo-I2V

Creación de Contenido Digital: Permite a los creadores de contenido transformar imágenes promocionales estáticas en contenido de video atractivo para redes sociales y publicidad

Animación Educativa: Convierte diagramas e ilustraciones educativas en videos animados para una mejor comprensión y participación en los materiales de aprendizaje

Producción de Efectos Especiales: Permite a los cineastas y productores de video crear efectos especiales personalizados a través del entrenamiento LoRA para transiciones y animaciones visuales únicas

Animación Artística: Ayuda a los artistas a dar vida a sus obras de arte estáticas a través de la animación automatizada, creando versiones dinámicas de pinturas o ilustraciones

Ventajas

Disponibilidad de código abierto con documentación completa

Salida de alta calidad con resolución de hasta 720P

Control flexible sobre la dinámica y el movimiento del video

Soporte para efectos personalizables a través del entrenamiento LoRA

Desventajas

Altos requisitos de hardware (mínimo 60 GB de memoria GPU)

Limitado al sistema operativo Linux

Duración máxima del video restringida a 5 segundos (129 fotogramas)

Cómo Usar HunyuanVideo-I2V

1. Verificación de requisitos del sistema: Asegúrese de tener: 1) GPU NVIDIA con un mínimo de 60 GB de memoria (se recomiendan 80 GB) para la generación de video de 720p 2) Sistema operativo Linux 3) Soporte de CUDA

2. Instalar dependencias: Ejecute estos comandos en secuencia:

1. git clone https://github.com/Tencent-Hunyuan/HunyuanVideo-I2V

2. cd HunyuanVideo-I2V

3. conda create -n HunyuanVideo-I2V python==3.11.9

4. conda activate HunyuanVideo-I2V

5. conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia

6. python -m pip install -r requirements.txt

7. python -m pip install ninja

8. python -m pip install git+https://github.com/Dao-AILab/[email protected]

9. python -m pip install xfuser==0.4.0

3. Descargar modelos pre-entrenados: Siga las instrucciones en ckpts/README.md para descargar los pesos del modelo requeridos

4. Generar video estable: Ejecute el comando:

python3 sample_image2video.py \

--model HYVideo-T/2 \

--prompt "[su prompt]" \

--i2v-mode \

--i2v-image-path [ruta a la imagen de entrada] \

--i2v-resolution 720p \

--i2v-stability \

--infer-steps 50 \

--video-length 129 \

--flow-reverse \

--flow-shift 7.0 \

--seed 0 \

--embedded-cfg-scale 6.0 \

--use-cpu-offload \

--save-path ./results

5. Generar video dinámico: Similar al paso 4, pero elimine el indicador --i2v-stability y cambie --flow-shift a 17.0 para un movimiento más dinámico

6. Opcional: Procesamiento paralelo multi-GPU: Para un procesamiento más rápido en múltiples GPU, use:

ALLOW_RESIZE_FOR_SP=1 torchrun --nproc_per_node=8 \

sample_image2video.py [otros parámetros como en el paso 4] \

--ulysses-degree 8 \

--ring-degree 1

7. Consejos para obtener los mejores resultados: 1. Use prompts concisos

2. Incluya el tema principal, la acción y el ángulo de la cámara/fondo opcional

3. Evite prompts demasiado detallados

4. Use --i2v-stability para videos estables

5. Ajuste --flow-shift entre 7.0 (estable) y 17.0 (dinámico) según las necesidades

Preguntas Frecuentes de HunyuanVideo-I2V

La memoria mínima de la GPU requerida es de 60 GB para la generación de video de 720p. Se recomienda una GPU con 80 GB de memoria para una mejor calidad de generación. El modelo requiere una GPU NVIDIA con soporte CUDA y ha sido probado en el sistema operativo Linux.

Video de HunyuanVideo-I2V

Artículos Populares

Tutorial de Atoms 2026: Construye un Panel de Control SaaS Completo en 20 Minutos (Práctica con AIPURE)

Mar 2, 2026

Códigos de cupón de OpenArt AI gratuitos en 2026 y cómo canjearlos

Feb 25, 2026

Herramientas de IA más populares de 2025 | Actualización de 2026 por AIPURE

Feb 10, 2026

Moltbook AI: La primera red social de agentes de IA pura de 2026

Feb 5, 2026