Agenta

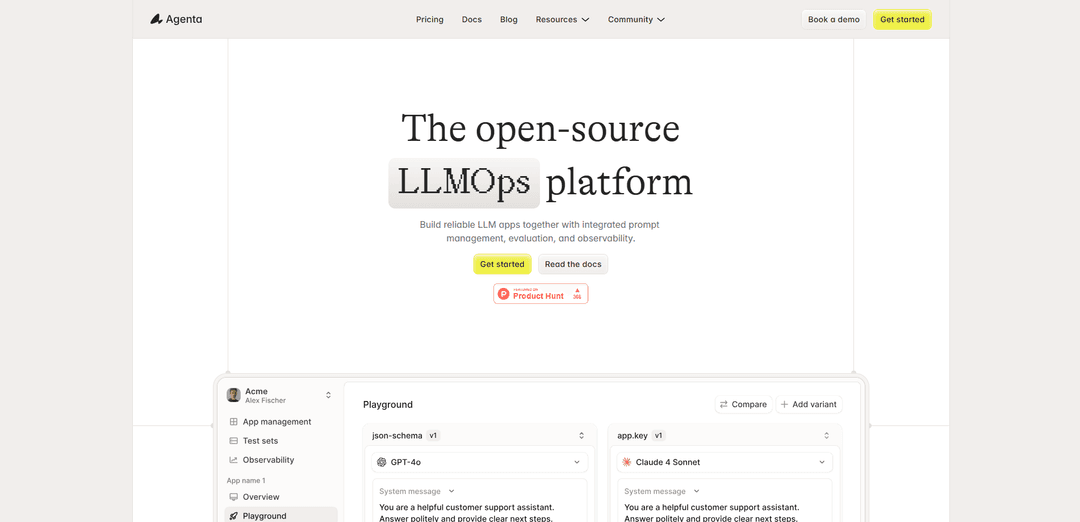

Agenta ist eine Open-Source-LLMOps-Plattform, die integrierte Tools f\u00fcr Prompt Engineering, Bewertung, Debugging und \u00dcberwachung bietet, um Entwicklern und Produktteams beim Erstellen zuverl\u00e4ssiger LLM-Anwendungen zu helfen.

https://www.agenta.ai/?ref=producthunt&utm_source=aipure

Produktinformationen

Aktualisiert:Dec 9, 2025

Was ist Agenta

Agenta ist eine umfassende End-to-End-Plattform, die entwickelt wurde, um die Entwicklung und Bereitstellung von Large Language Model (LLM)-Anwendungen zu optimieren. Sie dient als einheitlicher Arbeitsbereich, in dem sowohl technische als auch nicht-technische Teammitglieder effektiv bei der Erstellung von KI-Anwendungen zusammenarbeiten k\u00f6nnen. Die Plattform \u00fcberbr\u00fcckt die Kluft zwischen verstreuten Arbeitsabl\u00e4ufen und strukturierten Prozessen, indem sie eine wesentliche Infrastruktur und Tools bereitstellt, die den LLMOps Best Practices folgen, wodurch es Teams erleichtert wird, Prompts zu verwalten, Bewertungen durchzuf\u00fchren und ihre LLM-Anwendungen an einem zentralen Ort zu \u00fcberwachen.

Hauptfunktionen von Agenta

Agenta ist eine Open-Source-LLMOps-Plattform, die umfassende Tools zum Erstellen, Evaluieren und Bereitstellen von LLM-Anwendungen bietet. Sie bietet integriertes Prompt-Management, Versionierung, Evaluierung und Beobachtungsfunktionen, die es Teams ermöglichen, ihren LLM-Entwicklungs-Workflow zu optimieren. Die Plattform unterstützt verschiedene LLM-Frameworks wie Langchain und LlamaIndex, funktioniert mit jedem Modellanbieter und erleichtert die Zusammenarbeit zwischen technischen und nicht-technischen Teammitgliedern über eine einheitliche Schnittstelle.

Einheitliches Prompt-Management: Zentrale Plattform zum Speichern, Versionieren und Verwalten von Prompts mit Side-by-Side-Vergleichsfunktionen und vollständiger Verfolgung des Versionsverlaufs

Systematisches Evaluierungs-Framework: Umfassende Evaluierungstools, einschliesslich automatisierter Tests, LLM-as-a-Judge-Funktionalität und Integration von menschlichem Feedback zur Qualitätsbeurteilung

Erweiterte Beobachtbarkeit: Echtzeitüberwachung und -verfolgung von LLM-Anwendungen mit detaillierten Einblicken in Kosten, Latenz und Leistungsmetriken

Kollaborative Schnittstelle: Benutzerfreundliche Benutzeroberfläche, die es sowohl technischen als auch nicht-technischen Teammitgliedern ermöglicht, sich an Prompt-Engineering und -Evaluierung zu beteiligen, ohne Code zu berühren

Anwendungsfälle von Agenta

KI-Anwendungsentwicklung: Teams, die LLM-gestützte Anwendungen entwickeln, können Agenta verwenden, um Entwicklungs-, Test- und Bereitstellungsprozesse zu optimieren

Qualitätssicherung: Organisationen können systematische Tests und Bewertungen von KI-Ausgaben implementieren, um Konsistenz und Zuverlässigkeit sicherzustellen

Funktionsübergreifende Zusammenarbeit: Produktteams und Fachexperten können mit Entwicklern zusammenarbeiten, um KI-Anwendungen durch gemeinsame Workflows und Tools zu optimieren

Vorteile

Open-Source und Framework-agnostisch

Umfassende End-to-End-LLMOps-Lösung

Starke Funktionen für die Zusammenarbeit zwischen funktionsübergreifenden Teams

Nachteile

Begrenzte Dokumentation für erweiterte Funktionen

Erfordert anfängliche technische Einrichtung und Integration

Wie verwendet man Agenta

Anmelden/Zugreifen: Greifen Sie entweder \u00fcber die Agenta Cloud auf Agenta zu (einfachste M\u00f6glichkeit, um loszulegen) oder richten Sie sie lokal unter http://localhost ein

Projekteinrichtung: Erstellen Sie ein neues Projekt und integrieren Sie Agenta in Ihre bestehende LLM-Anwendungscodebasis (unterst\u00fctzt LangChain, LlamaIndex, OpenAI und andere Frameworks)

Prompt Engineering: Nutzen Sie die einheitliche Playground-Umgebung, um mit verschiedenen Prompts und Modellen nebeneinander zu experimentieren und diese zu vergleichen. Testen Sie Prompts interaktiv, um Ausgaben zu verfeinern und zu optimieren

Versionskontrolle: Verfolgen Sie \u00c4nderungen und versionieren Sie Ihre Prompts mithilfe des Versionskontrollsystems von Agenta. F\u00fchren Sie eine vollst\u00e4ndige Historie von Prompt-Iterationen und \u00c4nderungen

Testdatens\u00e4tze erstellen: Erstellen Sie Testdatens\u00e4tze aus Produktionsfehlern oder Grenzf\u00e4llen. Speichern Sie problematische Ausgaben in Testdatens\u00e4tzen, die in der Playground-Umgebung zum Debuggen verwendet werden k\u00f6nnen

Bewertungen einrichten: Erstellen Sie systematische Bewertungsprozesse mithilfe von integrierten Evaluatoren, LLM-as-Judge oder benutzerdefinierten Code-Evaluatoren, um \u00c4nderungen zu validieren und Ergebnisse zu verfolgen

\u00dcberwachung konfigurieren: Richten Sie Tracing und Observability ein, um Ihre LLM-Anwendung in der Produktion zu \u00fcberwachen. Verfolgen Sie Nutzungsmuster und erkennen Sie Leistungsprobleme

Teamzusammenarbeit: Laden Sie Teammitglieder (Entwickler, Produktmanager, Fachexperten) ein, \u00fcber die Benutzeroberfl\u00e4che zusammenzuarbeiten, um mit Prompts zu experimentieren und Bewertungen durchzuf\u00fchren

\u00c4nderungen bereitstellen: Stellen Sie genehmigte Prompt-\u00c4nderungen und -Konfigurationen \u00fcber die Benutzeroberfl\u00e4che, CLI oder GitHub-Workflows in der Produktion bereit

Kontinuierliche Verbesserung: Nutzen Sie den Feedback-Loop zur kontinuierlichen Verbesserung, indem Sie Traces in Tests umwandeln, Benutzerfeedback sammeln und die Live-Performance \u00fcberwachen

Agenta FAQs

Agenta ist eine Open-Source-LLMOps-Plattform, die Infrastruktur für LLM-Entwicklungsteams bereitstellt und integriertes Prompt-Management, Evaluierungs- und Observability-Tools bietet, um Teams beim Aufbau zuverlässiger LLM-Anwendungen zu unterstützen.

Beliebte Artikel

Die beliebtesten KI-Tools von 2025 | 2026 Update von AIPURE

Feb 10, 2026

Moltbook AI: Das erste reine KI-Agenten-Netzwerk von 2026

Feb 5, 2026

ThumbnailCreator: Das KI-Tool, das Ihren YouTube-Thumbnail-Stress löst (2026)

Jan 16, 2026

KI-Smartglasses 2026: Eine Software-orientierte Perspektive auf den Markt für tragbare KI

Jan 7, 2026