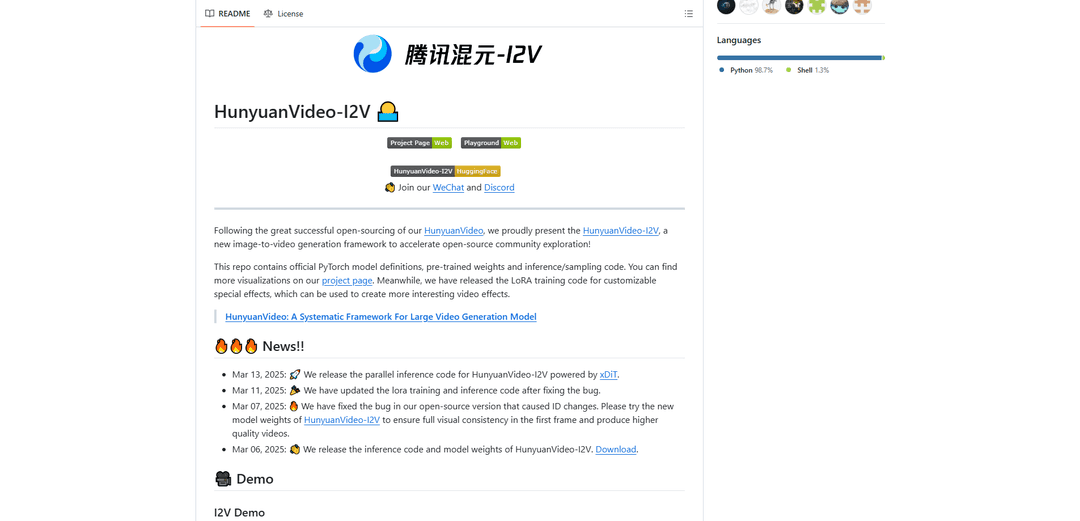

HunyuanVideo-I2V

HunyuanVideo-I2V 是腾讯开发的开源 AI 框架,可将静态图像转换为具有可定制运动效果和卓越视觉一致性的高质量动态视频。

https://github.com/Tencent/HunyuanVideo-I2V?ref=producthunt&utm_source=aipure

产品信息

更新于:2025年12月09日

什么是 HunyuanVideo-I2V

HunyuanVideo-I2V 是一个基于成功的 HunyuanVideo 基础模型的尖端图像到视频生成模型。它由腾讯的 Hunyuan 实验室发布,代表了 AI 驱动的视频合成方面的一个重大进步,能够生成高达 720P 分辨率和 129 帧(5 秒)长度的视频。该框架旨在弥合静态图像和动态视频内容之间的差距,提供稳定和高动态运动选项,以满足不同的创意需求。它配备了全面的定制工具,包括用于专门视频效果的 LoRA 训练功能。

HunyuanVideo-I2V 的主要功能

HunyuanVideo-I2V是由腾讯开发的一款先进的开源图像到视频生成框架,可以将静态图像转换为高质量的动态视频。它利用预训练的多模态大型语言模型,采用Decoder-Only架构,能够全面理解图像和文本输入。该框架支持高达720P的高分辨率视频生成,视频长度最长可达129帧(5秒),并提供稳定和动态视频生成模式选项。

统一的图像和视频架构: 采用具有全注意力机制的Transformer设计,支持图像和视频的统一生成,实现图像和文本信息的无缝集成

可定制的运动控制: 通过稳定性设置和流动偏移参数,提供对视频动态的灵活控制,允许用户生成稳定或高度动态的视频

高分辨率输出: 能够生成高达720P分辨率的高质量视频,帧数为129帧,在整个生成过程中保持视觉一致性

LoRA训练支持: 包括用于可定制特效的LoRA训练功能,允许用户训练和应用特定的视频效果到他们的生成中

HunyuanVideo-I2V 的使用场景

数字内容创作: 使内容创作者能够将静态的宣传图像转换为引人入胜的视频内容,用于社交媒体和广告

教育动画: 将教育图表和插图转换为动画视频,以更好地理解和参与学习材料

特效制作: 允许电影制作人和视频制作人通过LoRA训练创建自定义特效,以实现独特的视觉过渡和动画

艺术动画: 帮助艺术家通过自动化动画将他们的静态艺术作品变为现实,创建绘画或插图的动态版本

优点

开源可用,并提供全面的文档

高质量输出,分辨率高达720P

对视频动态和运动的灵活控制

支持通过LoRA训练进行可定制的效果

缺点

硬件要求高(至少60GB GPU内存)

仅限于Linux操作系统

最大视频长度限制为5秒(129帧)

如何使用 HunyuanVideo-I2V

1. 系统要求检查: 确保您具备:1) NVIDIA GPU,至少 60GB 内存(建议 80GB)用于 720p 视频生成 2) Linux 操作系统 3) CUDA 支持

2. 安装依赖项: 按顺序运行以下命令:

1. git clone https://github.com/Tencent-Hunyuan/HunyuanVideo-I2V

2. cd HunyuanVideo-I2V

3. conda create -n HunyuanVideo-I2V python==3.11.9

4. conda activate HunyuanVideo-I2V

5. conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia

6. python -m pip install -r requirements.txt

7. python -m pip install ninja

8. python -m pip install git+https://github.com/Dao-AILab/[email protected]

9. python -m pip install xfuser==0.4.0

3. 下载预训练模型: 按照 ckpts/README.md 中的说明下载所需的模型权重

4. 生成稳定视频: 运行命令:

python3 sample_image2video.py \

--model HYVideo-T/2 \

--prompt "[您的提示语]" \

--i2v-mode \

--i2v-image-path [输入图像的路径] \

--i2v-resolution 720p \

--i2v-stability \

--infer-steps 50 \

--video-length 129 \

--flow-reverse \

--flow-shift 7.0 \

--seed 0 \

--embedded-cfg-scale 6.0 \

--use-cpu-offload \

--save-path ./results

5. 生成动态视频: 与步骤 4 类似,但删除 --i2v-stability 标志并将 --flow-shift 更改为 17.0 以获得更动态的运动

6. 可选:多 GPU 并行处理: 为了在多个 GPU 上更快地处理,请使用:

ALLOW_RESIZE_FOR_SP=1 torchrun --nproc_per_node=8 \

sample_image2video.py [步骤 4 中的其他参数] \

--ulysses-degree 8 \

--ring-degree 1

7. 获得最佳结果的提示: 1. 使用简洁的提示语

2. 包括主要对象、动作和可选的背景/相机角度

3. 避免过于详细的提示语

4. 使用 --i2v-stability 来获得稳定的视频

5. 根据需要调整 --flow-shift 在 7.0(稳定)和 17.0(动态)之间

HunyuanVideo-I2V 常见问题

生成 720p 视频的最低 GPU 内存要求为 60GB。建议使用 80GB 内存的 GPU 以获得更好的生成质量。该模型需要支持 CUDA 的 NVIDIA GPU,并且已在 Linux 操作系统上进行过测试。