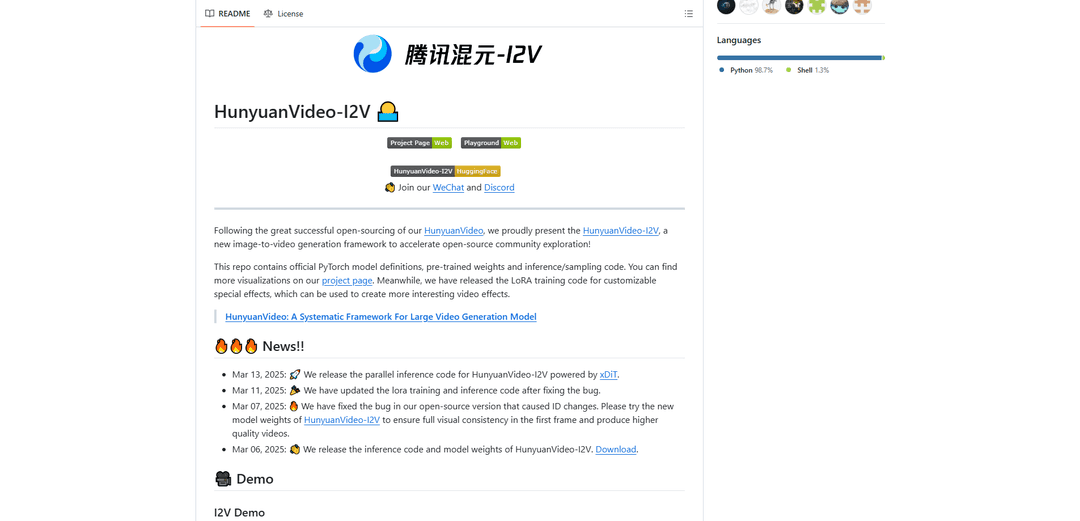

HunyuanVideo-I2V

HunyuanVideo-I2V è un framework AI open-source sviluppato da Tencent che trasforma immagini statiche in video dinamici di alta qualità con effetti di movimento personalizzabili ed eccezionale coerenza visiva.

https://github.com/Tencent/HunyuanVideo-I2V?ref=producthunt&utm_source=aipure

Informazioni sul Prodotto

Aggiornato:Dec 9, 2025

Cos'è HunyuanVideo-I2V

HunyuanVideo-I2V è un modello di generazione da immagine a video all'avanguardia basato sulla solida base di HunyuanVideo. Rilasciato dal Hunyuan Lab di Tencent, rappresenta un significativo progresso nella sintesi video basata sull'intelligenza artificiale, in grado di generare video fino a una risoluzione di 720P e 129 fotogrammi (5 secondi) di lunghezza. Il framework è progettato per colmare il divario tra immagini statiche e contenuti video dinamici, offrendo opzioni di movimento sia stabili che ad alta dinamicità per soddisfare diverse esigenze creative. Viene fornito con strumenti completi per la personalizzazione, incluse le capacità di training LoRA per effetti video specializzati.

Caratteristiche principali di HunyuanVideo-I2V

HunyuanVideo-I2V è un framework open-source avanzato per la generazione di immagini in video sviluppato da Tencent che trasforma immagini statiche in video dinamici di alta qualità. Sfrutta un modello linguistico multimodale di grandi dimensioni pre-addestrato con un'architettura Decoder-Only, consentendo una comprensione completa sia degli input di immagini che di testo. Il framework supporta la generazione di video ad alta risoluzione fino a 720P e una lunghezza del video fino a 129 fotogrammi (5 secondi), con opzioni per modalità di generazione video sia stabili che dinamiche.

Architettura unificata di immagini e video: Impiega un design Transformer con meccanismo di attenzione completa che supporta la generazione unificata di immagini e video, consentendo una perfetta integrazione di informazioni di immagini e testo

Controllo del movimento personalizzabile: Offre un controllo flessibile sulla dinamica video attraverso impostazioni di stabilità e parametri di spostamento del flusso, consentendo agli utenti di generare video stabili o altamente dinamici

Output ad alta risoluzione: In grado di generare video di alta qualità fino a una risoluzione di 720P con 129 fotogrammi, mantenendo la coerenza visiva durante tutto il processo di generazione

Supporto per l'addestramento LoRA: Include funzionalità di addestramento LoRA per effetti speciali personalizzabili, consentendo agli utenti di addestrare e applicare effetti video specifici alle loro generazioni

Casi d'uso di HunyuanVideo-I2V

Creazione di contenuti digitali: Consente ai creatori di contenuti di trasformare immagini promozionali statiche in contenuti video coinvolgenti per i social media e la pubblicità

Animazione educativa: Converte diagrammi e illustrazioni educative in video animati per una migliore comprensione e coinvolgimento nei materiali di apprendimento

Produzione di effetti speciali: Consente a registi e produttori video di creare effetti speciali personalizzati tramite l'addestramento LoRA per transizioni e animazioni visive uniche

Animazione artistica: Aiuta gli artisti a dare vita alle loro opere d'arte statiche attraverso l'animazione automatizzata, creando versioni dinamiche di dipinti o illustrazioni

Vantaggi

Disponibilità open-source con documentazione completa

Output di alta qualità con risoluzione fino a 720P

Controllo flessibile sulla dinamica e sul movimento del video

Supporto per effetti personalizzabili tramite l'addestramento LoRA

Svantaggi

Elevati requisiti hardware (minimo 60 GB di memoria GPU)

Limitato al sistema operativo Linux

Lunghezza massima del video limitata a 5 secondi (129 fotogrammi)

Come usare HunyuanVideo-I2V

1. Verifica dei requisiti di sistema: Assicurati di avere: 1) GPU NVIDIA con un minimo di 60 GB di memoria (80 GB consigliati) per la generazione di video a 720p 2) Sistema operativo Linux 3) Supporto CUDA

2. Installa le dipendenze: Esegui questi comandi in sequenza:

1. git clone https://github.com/Tencent-Hunyuan/HunyuanVideo-I2V

2. cd HunyuanVideo-I2V

3. conda create -n HunyuanVideo-I2V python==3.11.9

4. conda activate HunyuanVideo-I2V

5. conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia

6. python -m pip install -r requirements.txt

7. python -m pip install ninja

8. python -m pip install git+https://github.com/Dao-AILab/[email protected]

9. python -m pip install xfuser==0.4.0

3. Scarica i modelli pre-addestrati: Segui le istruzioni in ckpts/README.md per scaricare i pesi del modello richiesti

4. Genera video stabile: Esegui il comando:

python3 sample_image2video.py \

--model HYVideo-T/2 \

--prompt "[il tuo prompt]" \

--i2v-mode \

--i2v-image-path [percorso dell'immagine di input] \

--i2v-resolution 720p \

--i2v-stability \

--infer-steps 50 \

--video-length 129 \

--flow-reverse \

--flow-shift 7.0 \

--seed 0 \

--embedded-cfg-scale 6.0 \

--use-cpu-offload \

--save-path ./results

5. Genera video dinamico: Simile al passaggio 4, ma rimuovi il flag --i2v-stability e cambia --flow-shift a 17.0 per un movimento più dinamico

6. Opzionale: elaborazione parallela multi-GPU: Per un'elaborazione più rapida su più GPU, usa:

ALLOW_RESIZE_FOR_SP=1 torchrun --nproc_per_node=8 \

sample_image2video.py [altri parametri come nel passaggio 4] \

--ulysses-degree 8 \

--ring-degree 1

7. Suggerimenti per risultati ottimali: 1. Usa prompt concisi

2. Includi soggetto principale, azione e angolo di ripresa/sfondo opzionale

3. Evita prompt eccessivamente dettagliati

4. Usa --i2v-stability per video stabili

5. Regola --flow-shift tra 7.0 (stabile) e 17.0 (dinamico) in base alle esigenze

FAQ di HunyuanVideo-I2V

La memoria GPU minima richiesta e' di 60GB per la generazione di video a 720p. Si consiglia una GPU con 80GB di memoria per una migliore qualita' di generazione. Il modello richiede una GPU NVIDIA con supporto CUDA ed e' stato testato sul sistema operativo Linux.

Video di HunyuanVideo-I2V

Articoli Popolari

Tutorial di Atoms 2026: Crea una dashboard SaaS completa in 20 minuti (AIPURE Pratico)

Mar 2, 2026

Strumenti di IA più popolari del 2025 | Aggiornamento 2026 di AIPURE

Feb 10, 2026

Moltbook AI: la prima rete sociale di agenti AI puri del 2026

Feb 5, 2026

ThumbnailCreator: Lo strumento di intelligenza artificiale che risolve lo stress delle miniature di YouTube (2026)

Jan 16, 2026