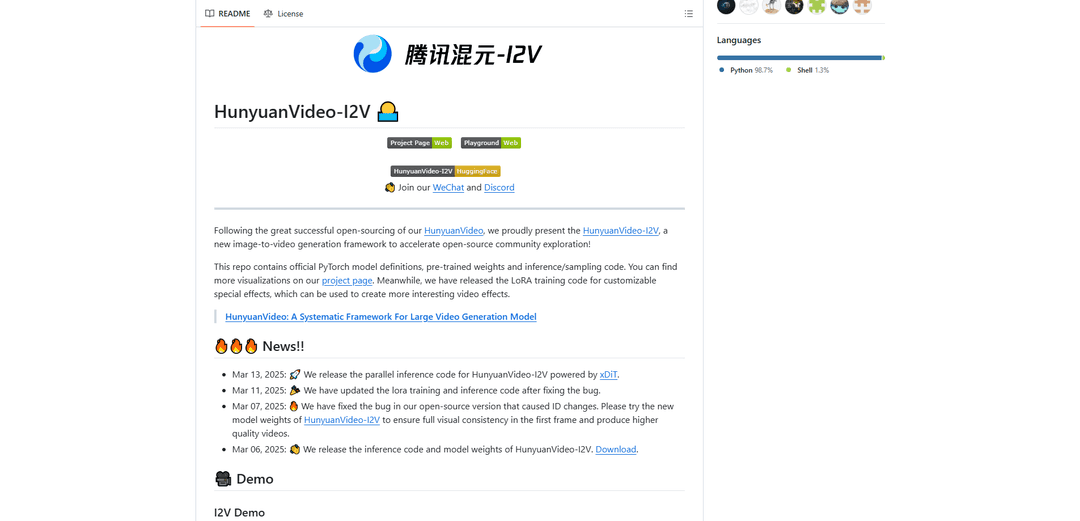

HunyuanVideo-I2V

HunyuanVideo-I2V est un framework d'IA open source développé par Tencent qui transforme des images statiques en vidéos dynamiques de haute qualité avec des effets de mouvement personnalisables et une cohérence visuelle exceptionnelle.

https://github.com/Tencent/HunyuanVideo-I2V?ref=producthunt&utm_source=aipure

Informations sur le produit

Mis à jour:Dec 9, 2025

Qu'est-ce que HunyuanVideo-I2V

HunyuanVideo-I2V est un modèle de génération image-vidéo de pointe basé sur la fondation réussie HunyuanVideo. Publié par le laboratoire Hunyuan de Tencent, il représente une avancée significative dans la synthèse vidéo basée sur l'IA, capable de générer des vidéos jusqu'à une résolution de 720P et 129 images (5 secondes) de longueur. Le framework est conçu pour combler le fossé entre l'imagerie statique et le contenu vidéo dynamique, offrant des options de mouvement à la fois stables et à haute dynamique pour répondre à différents besoins créatifs. Il est livré avec des outils complets de personnalisation, y compris des capacités de formation LoRA pour des effets vidéo spécialisés.

Caractéristiques principales de HunyuanVideo-I2V

HunyuanVideo-I2V est un framework open source avancé de génération image-vidéo développé par Tencent qui transforme des images statiques en vidéos dynamiques de haute qualité. Il exploite un grand modèle de langage multimodal pré-entraîné avec une architecture Decoder-Only, permettant une compréhension complète des entrées d'image et de texte. Le framework prend en charge la génération de vidéos haute résolution jusqu'à 720P et une longueur de vidéo jusqu'à 129 images (5 secondes), avec des options pour les modes de génération de vidéos stables et dynamiques.

Architecture unifiée d'image et de vidéo: Utilise une conception Transformer avec un mécanisme d'attention complet qui prend en charge la génération unifiée d'images et de vidéos, permettant une intégration transparente des informations d'image et de texte

Contrôle de mouvement personnalisable: Offre un contrôle flexible sur la dynamique vidéo grâce aux paramètres de stabilité et aux paramètres de décalage de flux, permettant aux utilisateurs de générer des vidéos stables ou très dynamiques

Sortie haute résolution: Capable de générer des vidéos de haute qualité jusqu'à une résolution de 720P avec 129 images, en maintenant la cohérence visuelle tout au long du processus de génération

Support de formation LoRA: Comprend des capacités de formation LoRA pour des effets spéciaux personnalisables, permettant aux utilisateurs de former et d'appliquer des effets vidéo spécifiques à leurs générations

Cas d'utilisation de HunyuanVideo-I2V

Création de contenu numérique: Permet aux créateurs de contenu de transformer des images promotionnelles statiques en contenu vidéo attrayant pour les médias sociaux et la publicité

Animation éducative: Convertit des diagrammes et illustrations éducatifs en vidéos animées pour une meilleure compréhension et un engagement accru dans les supports d'apprentissage

Production d'effets spéciaux: Permet aux cinéastes et aux producteurs vidéo de créer des effets spéciaux personnalisés grâce à la formation LoRA pour des transitions visuelles et des animations uniques

Animation artistique: Aide les artistes à donner vie à leurs œuvres d'art statiques grâce à l'animation automatisée, en créant des versions dynamiques de peintures ou d'illustrations

Avantages

Disponibilité open source avec une documentation complète

Sortie de haute qualité avec une résolution allant jusqu'à 720P

Contrôle flexible sur la dynamique et le mouvement de la vidéo

Prise en charge des effets personnalisables grâce à la formation LoRA

Inconvénients

Exigences matérielles élevées (minimum 60 Go de mémoire GPU)

Limité au système d'exploitation Linux

Longueur maximale de la vidéo limitée à 5 secondes (129 images)

Comment utiliser HunyuanVideo-I2V

1. Vérification des exigences du système: Assurez-vous d'avoir : 1) GPU NVIDIA avec un minimum de 60 Go de mémoire (80 Go recommandés) pour la génération de vidéos 720p 2) Système d'exploitation Linux 3) Prise en charge de CUDA

2. Installer les dépendances: Exécutez ces commandes dans l'ordre :

1. git clone https://github.com/Tencent-Hunyuan/HunyuanVideo-I2V

2. cd HunyuanVideo-I2V

3. conda create -n HunyuanVideo-I2V python==3.11.9

4. conda activate HunyuanVideo-I2V

5. conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia

6. python -m pip install -r requirements.txt

7. python -m pip install ninja

8. python -m pip install git+https://github.com/Dao-AILab/[email protected]

9. python -m pip install xfuser==0.4.0

3. Télécharger les modèles pré-entraînés: Suivez les instructions dans ckpts/README.md pour télécharger les poids du modèle requis

4. Générer une vidéo stable: Exécuter la commande :

python3 sample_image2video.py \

--model HYVideo-T/2 \

--prompt "[votre invite]" \

--i2v-mode \

--i2v-image-path [chemin vers l'image d'entrée] \

--i2v-resolution 720p \

--i2v-stability \

--infer-steps 50 \

--video-length 129 \

--flow-reverse \

--flow-shift 7.0 \

--seed 0 \

--embedded-cfg-scale 6.0 \

--use-cpu-offload \

--save-path ./results

5. Générer une vidéo dynamique: Semblable à l'étape 4, mais supprimez l'indicateur --i2v-stability et remplacez --flow-shift par 17.0 pour un mouvement plus dynamique

6. Facultatif : Traitement parallèle multi-GPU: Pour un traitement plus rapide sur plusieurs GPU, utilisez :

ALLOW_RESIZE_FOR_SP=1 torchrun --nproc_per_node=8 \

sample_image2video.py [autres paramètres comme à l'étape 4] \

--ulysses-degree 8 \

--ring-degree 1

7. Conseils pour de meilleurs résultats: 1. Utilisez des invites concises

2. Incluez le sujet principal, l'action et l'arrière-plan/l'angle de la caméra facultatifs

3. Évitez les invites trop détaillées

4. Utilisez --i2v-stability pour les vidéos stables

5. Ajustez --flow-shift entre 7.0 (stable) et 17.0 (dynamique) en fonction des besoins

FAQ de HunyuanVideo-I2V

La mémoire GPU minimale requise est de 60 Go pour la génération de vidéos en 720p. Un GPU avec 80 Go de mémoire est recommandé pour une meilleure qualité de génération. Le modèle nécessite un GPU NVIDIA avec prise en charge de CUDA et a été testé sur le système d\'exploitation Linux.

Vidéo de HunyuanVideo-I2V

Articles populaires

Tutoriel Atoms 2026 : Créez un tableau de bord SaaS complet en 20 minutes (AIPURE Prise en main)

Mar 2, 2026

Outils d'IA les plus populaires de 2025 | Mise à jour 2026 par AIPURE

Feb 10, 2026

Moltbook AI : Le premier réseau social d'agents d'IA pure de 2026

Feb 5, 2026

ThumbnailCreator : L'outil d'IA qui résout votre stress lié aux miniatures YouTube (2026)

Jan 16, 2026