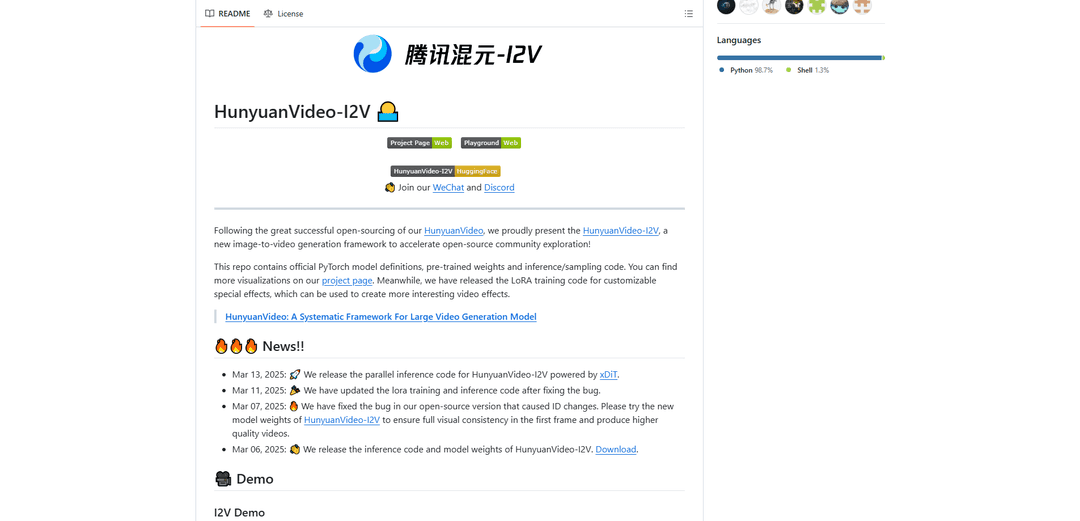

HunyuanVideo-I2V

HunyuanVideo-I2V ist ein Open-Source-KI-Framework, das von Tencent entwickelt wurde und statische Bilder in hochwertige, dynamische Videos mit anpassbaren Bewegungseffekten und außergewöhnlicher visueller Konsistenz umwandelt.

https://github.com/Tencent/HunyuanVideo-I2V?ref=producthunt&utm_source=aipure

Produktinformationen

Aktualisiert:Dec 9, 2025

Was ist HunyuanVideo-I2V

HunyuanVideo-I2V ist ein hochmodernes Image-to-Video-Generierungsmodell, das auf der erfolgreichen HunyuanVideo-Grundlage basiert. Es wurde von Tencents Hunyuan Lab veröffentlicht und stellt einen bedeutenden Fortschritt in der KI-gestützten Videosynthese dar, der Videos mit einer Auflösung von bis zu 720P und 129 Frames (5 Sekunden) Länge erzeugen kann. Das Framework wurde entwickelt, um die Lücke zwischen statischen Bildern und dynamischen Videoinhalten zu schließen und bietet sowohl Stabilität als auch hochdynamische Bewegungsoptionen, um unterschiedlichen kreativen Anforderungen gerecht zu werden. Es verfügt über umfassende Tools zur Anpassung, einschließlich LoRA-Trainingsfunktionen für spezielle Videoeffekte.

Hauptfunktionen von HunyuanVideo-I2V

HunyuanVideo-I2V ist ein fortschrittliches Open-Source-Framework zur Bild-zu-Video-Generierung, das von Tencent entwickelt wurde und statische Bilder in hochwertige, dynamische Videos umwandelt. Es nutzt ein vortrainiertes, multimodales, großes Sprachmodell mit einer reinen Decoder-Architektur, das ein umfassendes Verständnis von Bild- und Texteingaben ermöglicht. Das Framework unterstützt die Generierung von hochauflösenden Videos bis zu 720P und einer Videolänge von bis zu 129 Frames (5 Sekunden) mit Optionen für stabile und dynamische Videogenerierungsmodi.

Einheitliche Bild- und Videoarchitektur: Verwendet ein Transformer-Design mit vollem Aufmerksamkeitsmechanismus, das die einheitliche Generierung von Bildern und Videos unterstützt und eine nahtlose Integration von Bild- und Textinformationen ermöglicht

Anpassbare Bewegungssteuerung: Bietet flexible Kontrolle über die Videodynamik durch Stabilitätseinstellungen und Flussverschiebungs-Parameter, sodass Benutzer entweder stabile oder hochdynamische Videos generieren können

Hochauflösende Ausgabe: Kann hochwertige Videos mit einer Auflösung von bis zu 720P mit 129 Frames generieren und dabei die visuelle Konsistenz während des gesamten Generierungsprozesses beibehalten

LoRA-Trainingsunterstützung: Beinhaltet LoRA-Trainingsfunktionen für anpassbare Spezialeffekte, sodass Benutzer bestimmte Videoeffekte trainieren und auf ihre Generierungen anwenden können

Anwendungsfälle von HunyuanVideo-I2V

Erstellung digitaler Inhalte: Ermöglicht es Content-Erstellern, statische Werbebilder in ansprechende Videoinhalte für soziale Medien und Werbung umzuwandeln

Pädagogische Animation: Konvertiert pädagogische Diagramme und Illustrationen in animierte Videos, um das Verständnis und die Beteiligung an Lernmaterialien zu verbessern

Spezialeffektproduktion: Ermöglicht Filmemachern und Videoproduzenten, benutzerdefinierte Spezialeffekte durch LoRA-Training für einzigartige visuelle Übergänge und Animationen zu erstellen

Kunstanimation: Hilft Künstlern, ihre statischen Kunstwerke durch automatisierte Animation zum Leben zu erwecken und dynamische Versionen von Gemälden oder Illustrationen zu erstellen

Vorteile

Open-Source-Verfügbarkeit mit umfassender Dokumentation

Hochwertige Ausgabe mit einer Auflösung von bis zu 720P

Flexible Kontrolle über Videodynamik und -bewegung

Unterstützung für anpassbare Effekte durch LoRA-Training

Nachteile

Hohe Hardwareanforderungen (mindestens 60 GB GPU-Speicher)

Beschränkt auf das Linux-Betriebssystem

Maximale Videolänge auf 5 Sekunden begrenzt (129 Frames)

Wie verwendet man HunyuanVideo-I2V

1. Überprüfung der Systemanforderungen: Stellen Sie sicher, dass Sie Folgendes haben: 1) NVIDIA-GPU mit mindestens 60 GB Speicher (80 GB empfohlen) für die 720p-Videoerzeugung 2) Linux-Betriebssystem 3) CUDA-Unterstützung

2. Abhängigkeiten installieren: Führen Sie diese Befehle nacheinander aus:

1. git clone https://github.com/Tencent-Hunyuan/HunyuanVideo-I2V

2. cd HunyuanVideo-I2V

3. conda create -n HunyuanVideo-I2V python==3.11.9

4. conda activate HunyuanVideo-I2V

5. conda install pytorch==2.4.0 torchvision==0.19.0 torchaudio==2.4.0 pytorch-cuda=12.4 -c pytorch -c nvidia

6. python -m pip install -r requirements.txt

7. python -m pip install ninja

8. python -m pip install git+https://github.com/Dao-AILab/[email protected]

9. python -m pip install xfuser==0.4.0

3. Vorab trainierte Modelle herunterladen: Befolgen Sie die Anweisungen in ckpts/README.md, um die erforderlichen Modellgewichte herunterzuladen

4. Stabiles Video generieren: Befehl ausführen:

python3 sample_image2video.py \

--model HYVideo-T/2 \

--prompt "[Ihr Prompt]" \

--i2v-mode \

--i2v-image-path [Pfad zum Eingabebild] \

--i2v-resolution 720p \

--i2v-stability \

--infer-steps 50 \

--video-length 129 \

--flow-reverse \

--flow-shift 7.0 \

--seed 0 \

--embedded-cfg-scale 6.0 \

--use-cpu-offload \

--save-path ./results

5. Dynamisches Video generieren: Ähnlich wie Schritt 4, aber entfernen Sie das --i2v-stability-Flag und ändern Sie --flow-shift auf 17.0 für dynamischere Bewegungen

6. Optional: Parallele Multi-GPU-Verarbeitung: Für eine schnellere Verarbeitung auf mehreren GPUs verwenden Sie:

ALLOW_RESIZE_FOR_SP=1 torchrun --nproc_per_node=8 \

sample_image2video.py [andere Parameter wie in Schritt 4] \

--ulysses-degree 8 \

--ring-degree 1

7. Tipps für beste Ergebnisse: 1. Verwenden Sie prägnante Prompts

2. Fügen Sie Hauptmotiv, Aktion und optionalen Hintergrund/Kamerawinkel hinzu

3. Vermeiden Sie übermäßig detaillierte Prompts

4. Verwenden Sie --i2v-stability für stabile Videos

5. Passen Sie --flow-shift zwischen 7.0 (stabil) und 17.0 (dynamisch) basierend auf den Anforderungen an

HunyuanVideo-I2V FAQs

Der minimale GPU-Speicherbedarf beträgt 60 GB für die 720p-Videogenerierung. Eine GPU mit 80 GB Speicher wird für eine bessere Generierungsqualität empfohlen. Das Modell benötigt eine NVIDIA-GPU mit CUDA-Unterstützung und wurde unter dem Linux-Betriebssystem getestet.

HunyuanVideo-I2V Video

Beliebte Artikel

Atoms Tutorial 2026: Erstellen Sie ein vollständiges SaaS-Dashboard in 20 Minuten (AIPURE Hands-On)

Mar 2, 2026

Die beliebtesten KI-Tools von 2025 | 2026 Update von AIPURE

Feb 10, 2026

Moltbook AI: Das erste reine KI-Agenten-Netzwerk von 2026

Feb 5, 2026

ThumbnailCreator: Das KI-Tool, das Ihren YouTube-Thumbnail-Stress löst (2026)

Jan 16, 2026