Parallax by Gradient

Parallax è un motore di inferenza completamente decentralizzato che consente di creare cluster AI distribuiti per l'esecuzione di modelli linguistici di grandi dimensioni su più dispositivi, indipendentemente dalle loro configurazioni e posizioni fisiche.

https://github.com/GradientHQ/parallax?ref=producthunt&utm_source=aipure

Informazioni sul Prodotto

Aggiornato:Nov 16, 2025

Cos'è Parallax by Gradient

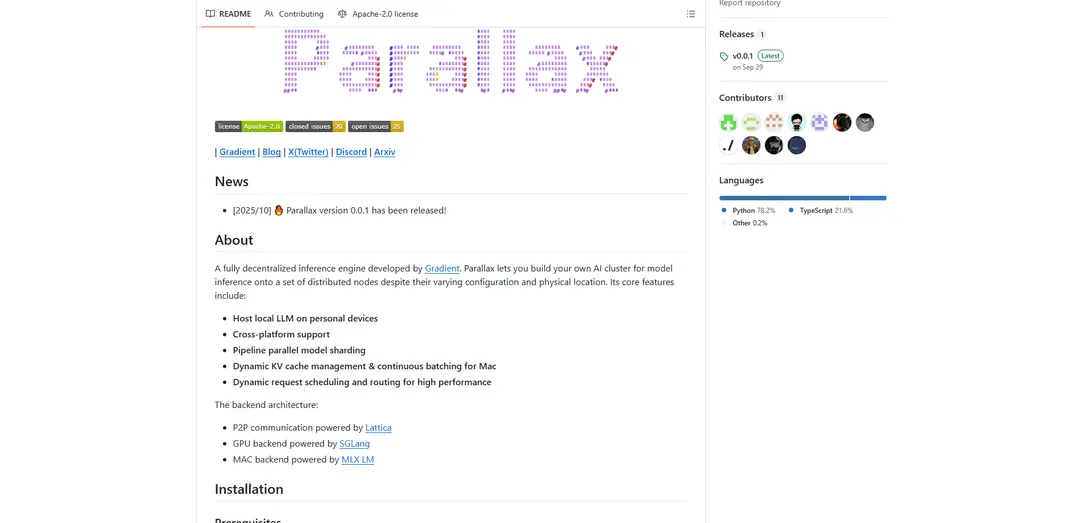

Parallax, sviluppato da Gradient, è un motore di inferenza open-source innovativo che reimmagina l'inferenza del modello come un processo globale e collaborativo. Si libera dalla tradizionale infrastruttura centralizzata consentendo la scomposizione, l'esecuzione e la verifica di modelli linguistici di grandi dimensioni su una rete distribuita di macchine. Il sistema supporta l'implementazione multipiattaforma su Windows, Linux e macOS, con compatibilità per varie architetture GPU tra cui le serie Blackwell, Ampere e Hopper.

Caratteristiche principali di Parallax by Gradient

Parallax è un motore di inferenza completamente decentralizzato che consente agli utenti di costruire il proprio cluster di AI distribuendo l'inferenza del modello su più nodi, indipendentemente dalla loro configurazione o posizione fisica. Offre supporto multipiattaforma, sharding efficiente del modello tramite parallelismo pipeline e funzionalità di gestione dinamica delle risorse, rendendo possibile l'esecuzione di modelli linguistici di grandi dimensioni su dispositivi personali mantenendo alte prestazioni.

Inferenza del Modello Distribuita: Consente di suddividere ed eseguire l'inferenza del modello su più nodi distribuiti, consentendo un uso efficiente delle risorse di calcolo disponibili

Compatibilità Multipiattaforma: Supporta più sistemi operativi tra cui Windows, Linux e macOS, con opzioni di installazione flessibili tramite codice sorgente, Docker o applicazioni native

Gestione Dinamica delle Risorse: Dispone di gestione dinamica della cache KV e batching continuo per Mac, insieme a pianificazione e routing intelligenti delle richieste per prestazioni ottimali

Architettura Parallela Pipeline: Implementa lo sharding del modello parallelo pipeline per distribuire in modo efficiente i livelli del modello su diversi nodi nel cluster

Casi d'uso di Parallax by Gradient

Infrastruttura AI Personale: Gli individui possono eseguire modelli linguistici di grandi dimensioni sui propri dispositivi personali combinando più risorse di calcolo

Ambiente di Ricerca Distribuito: Gli istituti di ricerca possono creare ambienti AI collaborativi collegando più computer in diverse sedi

Sviluppo Ottimizzato per le Risorse: Gli sviluppatori possono sfruttare l'infrastruttura hardware esistente distribuendo i carichi di lavoro del modello sui dispositivi disponibili

Vantaggi

Consente di eseguire modelli linguistici di grandi dimensioni su dispositivi personali

Opzioni di implementazione flessibili su diverse piattaforme

Utilizzo efficiente delle risorse tramite il calcolo distribuito

Svantaggi

Il processo di installazione può essere lungo (circa 30 minuti)

Alcune funzionalità sono specifiche della piattaforma (ad esempio, alcune funzionalità Docker sono limitate a Linux+GPU)

Come usare Parallax by Gradient

Verifica dei prerequisiti: Assicurati di avere installato Python versione 3.11.0 a 3.14.0. Per le GPU Blackwell, è richiesto Ubuntu 24.04.

Installazione: Scegli il metodo di installazione in base al tuo sistema operativo: gli utenti Windows possono scaricare il programma di installazione, gli utenti Linux/macOS installano dal sorgente, gli utenti Linux GPU possono utilizzare Docker. Per macOS, crea prima un ambiente virtuale Python.

Avvia Scheduler: Avvia lo scheduler sul tuo nodo principale eseguendo 'parallax run'. Accedi all'interfaccia di configurazione all'indirizzo http://localhost:3001. Per l'utilizzo non frontend, usa 'parallax run -m {model-name} -n {number-of-worker-nodes}'

Configura Cluster e Modello: Tramite l'interfaccia web, seleziona la configurazione del nodo e il modello desiderati dall'elenco supportato (inclusi DeepSeek, MiniMax-M2, GLM-4.6, Kimi-K2, Qwen, gpt-oss, Meta Llama 3)

Connetti Nodi: Su ogni nodo che vuoi connettere, esegui il comando di join: 'parallax join' per la rete locale o 'parallax join -s {scheduler-address}' per la rete pubblica

Inizia a Usare: Una volta che i nodi sono connessi, puoi utilizzare l'interfaccia di chat web all'indirizzo http://localhost:3001 o effettuare chiamate API a http://localhost:3001/v1/chat/completions per l'accesso programmatico

Accesso Remoto Opzionale: Per accedere all'interfaccia di chat da computer non scheduler, esegui 'parallax chat' per la rete locale o 'parallax chat -s {scheduler-address}' per la rete pubblica, quindi visita http://localhost:3002

Disinstallazione (se necessario): Per l'installazione pip: usa 'pip uninstall parallax'. Per Docker: rimuovi container e immagini usando i comandi docker. Per Windows: disinstalla tramite Pannello di controllo

FAQ di Parallax by Gradient

Parallax è un motore di inferenza completamente decentralizzato sviluppato da Gradient che consente agli utenti di costruire il proprio cluster AI per l'inferenza di modelli su nodi distribuiti, indipendentemente dalla loro configurazione e posizione fisica.

Video di Parallax by Gradient

Articoli Popolari

Tutorial di Atoms 2026: Crea una dashboard SaaS completa in 20 minuti (AIPURE Pratico)

Mar 2, 2026

Strumenti di IA più popolari del 2025 | Aggiornamento 2026 di AIPURE

Feb 10, 2026

Moltbook AI: la prima rete sociale di agenti AI puri del 2026

Feb 5, 2026

ThumbnailCreator: Lo strumento di intelligenza artificiale che risolve lo stress delle miniature di YouTube (2026)

Jan 16, 2026