Meta Llama 3.3 70B

Meta's Llama 3.3 70B è un modello di linguaggio all'avanguardia che offre prestazioni comparabili a quelle del modello più grande Llama 3.1 405B ma a un quinto del costo computazionale, rendendo l'IA di alta qualità più accessibile.

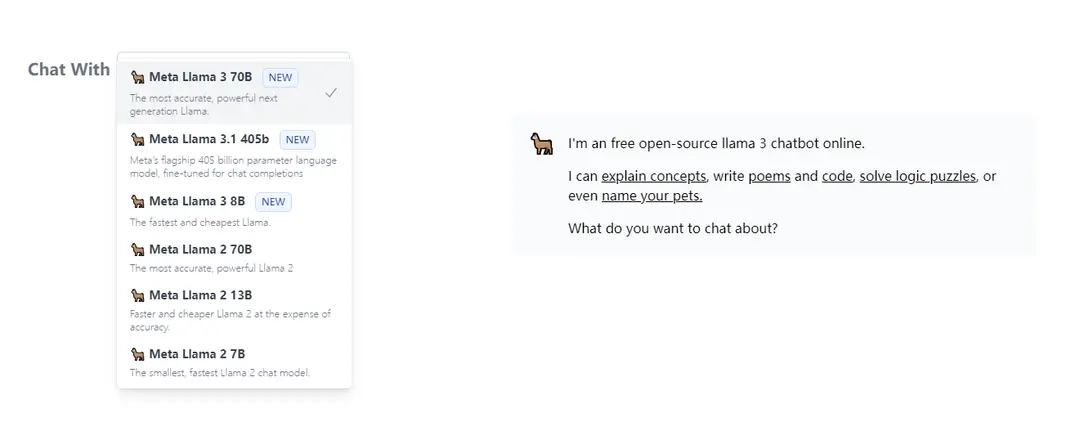

https://llama3.dev/?utm_source=aipure

Informazioni sul Prodotto

Aggiornato:Jul 16, 2025

Cos'è Meta Llama 3.3 70B

Meta Llama 3.3 70B è l'ultima iterazione nella famiglia di modelli di linguaggio di grandi dimensioni di Meta, rilasciata come loro modello finale per il 2024. Seguendo Llama 3.1 (8B, 70B, 405B) e Llama 3.2 (varianti multimodali), questo modello con 70B parametri solo testo rappresenta un significativo avanzamento nel design efficiente dei modelli di IA. Mantiene gli elevati standard di prestazione del suo predecessore più grande riducendo drasticamente i requisiti hardware, rendendolo più pratico per un'implementazione diffusa.

Caratteristiche principali di Meta Llama 3.3 70B

Meta Llama 3.3 70B è un modello linguistico di grandi dimensioni innovativo che offre prestazioni comparabili a quelle del modello molto più grande Llama 3.1 405B, ma a un quinto delle dimensioni e del costo computazionale. Sfrutta tecniche avanzate post-addestramento e un'architettura ottimizzata per ottenere risultati all'avanguardia in compiti di ragionamento, matematica e conoscenza generale, mantenendo alta efficienza e accessibilità per gli sviluppatori.

Prestazioni Efficiente: Raggiunge metriche di prestazione simili a Llama 3.1 405B utilizzando solo 70B parametri, rendendolo significativamente più efficiente in termini di risorse

Benchmark Avanzati: Ottiene 86.0 su MMLU Chat (0-shot, CoT) e 77.3 su BFCL v2 (0-shot), dimostrando forti capacità in compiti di conoscenza generale e utilizzo di strumenti

Inferenza Economica: Offre costi di generazione di token così bassi come $0.01 per milione di token, rendendolo altamente economico per distribuzioni in produzione

Supporto Multilingue: Supporta più lingue con la possibilità di essere ottimizzato per lingue aggiuntive mantenendo sicurezza e responsabilità

Casi d'uso di Meta Llama 3.3 70B

Elaborazione Documenti: Efficace per la sintesi e l'analisi di documenti in più lingue, come dimostrato da implementazioni di elaborazione di documenti giapponesi di successo

Sviluppo di Applicazioni AI: Ideale per gli sviluppatori che costruiscono applicazioni basate su testo che richiedono un'elaborazione linguistica di alta qualità senza risorse computazionali eccessive

Ricerca e Analisi: Adatto per la ricerca accademica e scientifica che richiede capacità avanzate di ragionamento e elaborazione della conoscenza

Vantaggi

Requisiti computazionali significativamente ridotti rispetto ai modelli più grandi

Prestazioni comparabili a modelli molto più grandi

Economico per distribuzioni in produzione

Svantaggi

Richiede ancora risorse computazionali sostanziali (anche se meno rispetto al modello 405B)

Alcuni divari di prestazione rispetto a Llama 3.1 405B in compiti specifici

Come usare Meta Llama 3.3 70B

Ottieni Accesso: Compila il modulo di richiesta di accesso su HuggingFace per ottenere accesso al repository riservato per Llama 3.3 70B. Genera un token READ di HuggingFace che è gratuito da creare.

Installa Dipendenze: Installa le dipendenze richieste, inclusa la libreria transformers e PyTorch

Carica il Modello: Importa e carica il modello utilizzando il seguente codice:

import transformers

import torch

model_id = 'meta-llama/Llama-3.3-70B-Instruct'

pipeline = transformers.pipeline('text-generation', model=model_id, model_kwargs={'torch_dtype': torch.bfloat16}, device_map='auto')

Formatta i Messaggi di Input: Struttura i tuoi messaggi di input come un elenco di dizionari con le chiavi 'role' e 'content'. Ad esempio:

messages = [

{'role': 'system', 'content': 'Sei un assistente utile'},

{'role': 'user', 'content': 'La tua domanda qui'}

]

Genera Output: Genera testo passando i messaggi alla pipeline:

outputs = pipeline(messages, max_new_tokens=256)

print(outputs[0]['generated_text'])

Requisiti Hardware: Assicurati di avere una memoria GPU adeguata. Il modello richiede significativamente meno risorse computazionali rispetto a Llama 3.1 405B pur offrendo prestazioni simili.

Segui la Politica di Utilizzo: Rispetta la Politica di Utilizzo Accettabile di Meta disponibile su https://www.llama.com/llama3_3/use-policy e assicurati che l'utilizzo sia conforme alle leggi e ai regolamenti applicabili

FAQ di Meta Llama 3.3 70B

Meta Llama 3.3 70B è un modello di linguaggio generativo (LLM) preaddestrato e ottimizzato per le istruzioni creato da Meta AI. È un modello multilingue che può elaborare e generare testo.

Post Ufficiali

Caricamento...Articoli Correlati

Articoli Popolari

Tutorial di Atoms 2026: Crea una dashboard SaaS completa in 20 minuti (AIPURE Pratico)

Mar 2, 2026

Strumenti di IA più popolari del 2025 | Aggiornamento 2026 di AIPURE

Feb 10, 2026

Moltbook AI: la prima rete sociale di agenti AI puri del 2026

Feb 5, 2026

ThumbnailCreator: Lo strumento di intelligenza artificiale che risolve lo stress delle miniature di YouTube (2026)

Jan 16, 2026

Analisi del Sito Web di Meta Llama 3.3 70B

Traffico e Classifiche di Meta Llama 3.3 70B

0

Visite Mensili

-

Classifica Globale

-

Classifica di Categoria

Tendenze del Traffico: Jul 2024-Jun 2025

Approfondimenti sugli Utenti di Meta Llama 3.3 70B

-

Durata Media della Visita

0

Pagine per Visita

0%

Tasso di Rimbalzo degli Utenti

Principali Regioni di Meta Llama 3.3 70B

Others: 100%