Meta Llama 3.3 70B

Le Llama 3.3 70B de Meta est un modèle de langage à la pointe de la technologie qui offre des performances comparables à celles du modèle plus grand Llama 3.1 405B mais à un cinquième du coût computationnel, rendant l'IA de haute qualité plus accessible.

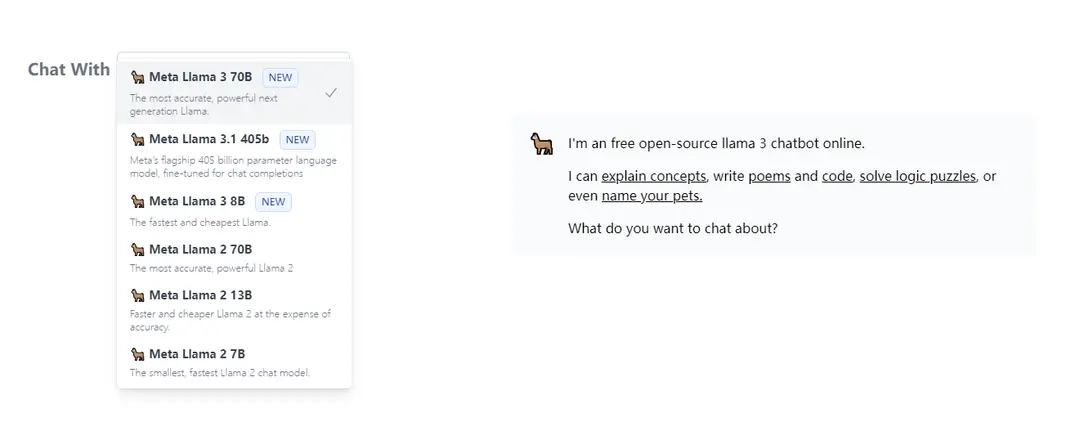

https://llama3.dev/?utm_source=aipure

Informations sur le produit

Mis à jour:Jul 16, 2025

Qu'est-ce que Meta Llama 3.3 70B

Meta Llama 3.3 70B est la dernière itération de la famille de grands modèles de langage Llama de Meta, publiée comme leur modèle final pour 2024. Suite à Llama 3.1 (8B, 70B, 405B) et Llama 3.2 (variantes multimodales), ce modèle à 70B paramètres uniquement textuel représente une avancée significative dans la conception de modèles d'IA efficaces. Il maintient les normes de haute performance de son prédécesseur plus grand tout en réduisant considérablement les exigences matérielles, le rendant plus pratique pour un déploiement généralisé.

Caractéristiques principales de Meta Llama 3.3 70B

Meta Llama 3.3 70B est un modèle de langage large révolutionnaire qui offre des performances comparables à celles du modèle beaucoup plus grand Llama 3.1 405B, mais à un cinquième de la taille et du coût computationnel. Il tire parti de techniques avancées de post-formation et d'une architecture optimisée pour atteindre des résultats à la pointe de la technologie dans les tâches de raisonnement, de mathématiques et de connaissances générales tout en maintenant une haute efficacité et accessibilité pour les développeurs.

Performance Efficace: Atteint des métriques de performance similaires à Llama 3.1 405B tout en utilisant seulement 70B de paramètres, ce qui le rend significativement plus économe en ressources

Références Avancées: Obtient un score de 86.0 sur MMLU Chat (0-shot, CoT) et 77.3 sur BFCL v2 (0-shot), démontrant de fortes capacités dans les tâches de connaissances générales et d'utilisation d'outils

Inférence Économique: Propose des coûts de génération de tokens aussi bas que 0,01 $ par million de tokens, ce qui le rend très économique pour les déploiements en production

Support Multilingue: Prend en charge plusieurs langues avec la capacité d'être affiné pour des langues supplémentaires tout en maintenant la sécurité et la responsabilité

Cas d'utilisation de Meta Llama 3.3 70B

Traitement de Documents: Efficace pour la synthèse et l'analyse de documents dans plusieurs langues, comme le montrent les mises en œuvre réussies du traitement de documents japonais

Développement d'Applications IA: Idéal pour les développeurs construisant des applications basées sur du texte nécessitant un traitement linguistique de haute qualité sans ressources computationnelles excessives

Recherche et Analyse: Adapté à la recherche académique et scientifique nécessitant des capacités avancées de raisonnement et de traitement des connaissances

Avantages

Exigences computationnelles significativement réduites par rapport aux modèles plus grands

Performance comparable à celle de modèles beaucoup plus grands

Économique pour le déploiement en production

Inconvénients

Nécessite encore des ressources computationnelles substantielles (bien que moins que le modèle 405B)

Certaines lacunes de performance par rapport à Llama 3.1 405B dans des tâches spécifiques

Comment utiliser Meta Llama 3.3 70B

Obtenir l'accès: Remplissez le formulaire de demande d'accès sur HuggingFace pour obtenir l'accès au dépôt sécurisé pour Llama 3.3 70B. Générez un jeton READ HuggingFace qui est gratuit à créer.

Installer les dépendances: Installez les dépendances requises, y compris la bibliothèque transformers et PyTorch

Charger le modèle: Importez et chargez le modèle en utilisant le code suivant :

import transformers

import torch

model_id = 'meta-llama/Llama-3.3-70B-Instruct'

pipeline = transformers.pipeline('text-generation', model=model_id, model_kwargs={'torch_dtype': torch.bfloat16}, device_map='auto')

Formater les messages d'entrée: Structurez vos messages d'entrée sous forme de liste de dictionnaires avec les clés 'role' et 'content'. Par exemple :

messages = [

{'role': 'system', 'content': 'Vous êtes un assistant utile'},

{'role': 'user', 'content': 'Votre question ici'}

]

Générer la sortie: Générez du texte en passant les messages au pipeline :

outputs = pipeline(messages, max_new_tokens=256)

print(outputs[0]['generated_text'])

Exigences matérielles: Assurez-vous d'avoir une mémoire GPU adéquate. Le modèle nécessite significativement moins de ressources informatiques par rapport à Llama 3.1 405B tout en offrant des performances similaires.

Suivre la politique d'utilisation: Respectez la politique d'utilisation acceptable de Meta disponible à https://www.llama.com/llama3_3/use-policy et assurez-vous que l'utilisation respecte les lois et règlements applicables

FAQ de Meta Llama 3.3 70B

Meta Llama 3.3 70B est un modèle de langage génératif (LLM) pré-entraîné et ajusté pour les instructions, créé par Meta AI. C'est un modèle multilingue capable de traiter et de générer du texte.

Publications officielles

Chargement...Articles connexes

Articles populaires

Tutoriel Atoms 2026 : Créez un tableau de bord SaaS complet en 20 minutes (AIPURE Prise en main)

Mar 2, 2026

Outils d'IA les plus populaires de 2025 | Mise à jour 2026 par AIPURE

Feb 10, 2026

Moltbook AI : Le premier réseau social d'agents d'IA pure de 2026

Feb 5, 2026

ThumbnailCreator : L'outil d'IA qui résout votre stress lié aux miniatures YouTube (2026)

Jan 16, 2026

Analyses du site web de Meta Llama 3.3 70B

Trafic et classements de Meta Llama 3.3 70B

0

Visites mensuelles

-

Classement mondial

-

Classement par catégorie

Tendances du trafic : Jul 2024-Jun 2025

Aperçu des utilisateurs de Meta Llama 3.3 70B

-

Durée moyenne de visite

0

Pages par visite

0%

Taux de rebond des utilisateurs

Principales régions de Meta Llama 3.3 70B

Others: 100%