Meta Llama 3.3 70B

O Llama 3.3 70B da Meta é um modelo de linguagem de ponta que oferece desempenho comparável ao maior modelo Llama 3.1 405B, mas a um quinto do custo computacional, tornando a IA de alta qualidade mais acessível.

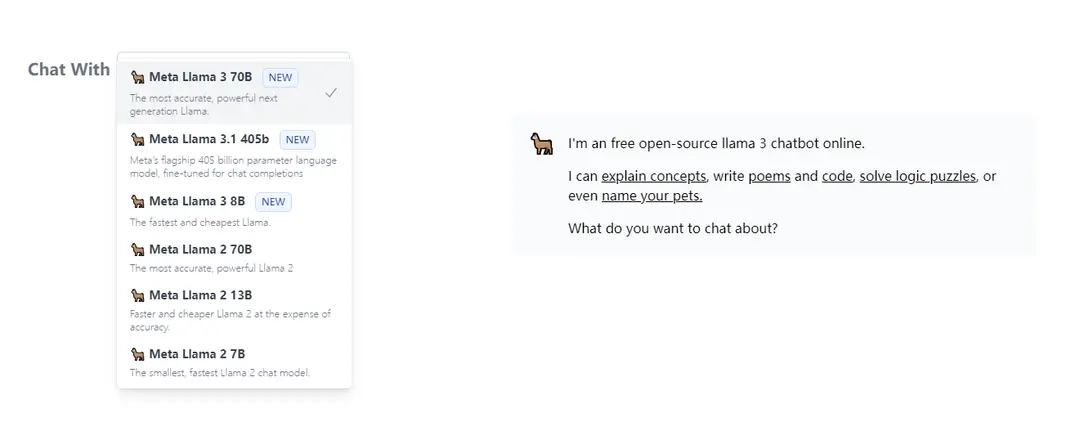

https://llama3.dev/?utm_source=aipure

Informações do Produto

Atualizado:Jul 16, 2025

O que é Meta Llama 3.3 70B

Meta Llama 3.3 70B é a última iteração da família de grandes modelos de linguagem Llama da Meta, lançada como seu modelo final para 2024. Seguindo o Llama 3.1 (8B, 70B, 405B) e o Llama 3.2 (variantes multimodais), este modelo de 70B parâmetros apenas de texto representa um avanço significativo no design eficiente de modelos de IA. Ele mantém os altos padrões de desempenho de seu predecessor maior, enquanto reduz drasticamente os requisitos de hardware, tornando-o mais prático para implantação em larga escala.

Principais Recursos do Meta Llama 3.3 70B

Meta Llama 3.3 70B é um modelo de linguagem grande inovador que oferece desempenho comparável ao modelo muito maior Llama 3.1 405B, mas com um quinto do tamanho e custo computacional. Ele utiliza técnicas avançadas de pós-treinamento e arquitetura otimizada para alcançar resultados de ponta em tarefas de raciocínio, matemática e conhecimento geral, mantendo alta eficiência e acessibilidade para desenvolvedores.

Desempenho Eficiente: Alcança métricas de desempenho semelhantes ao Llama 3.1 405B enquanto usa apenas 70B de parâmetros, tornando-o significativamente mais eficiente em termos de recursos

Benchmarks Avançados: Pontua 86.0 no MMLU Chat (0-shot, CoT) e 77.3 no BFCL v2 (0-shot), demonstrando fortes capacidades em tarefas de conhecimento geral e uso de ferramentas

Inferência Custo-Efetiva: Oferece custos de geração de tokens tão baixos quanto $0.01 por milhão de tokens, tornando-o altamente econômico para implantações em produção

Suporte Multilíngue: Suporta vários idiomas com a capacidade de ser ajustado para idiomas adicionais, mantendo segurança e responsabilidade

Casos de Uso do Meta Llama 3.3 70B

Processamento de Documentos: Eficaz para sumarização e análise de documentos em vários idiomas, como demonstrado por implementações bem-sucedidas de processamento de documentos em japonês

Desenvolvimento de Aplicações de IA: Ideal para desenvolvedores que criam aplicações baseadas em texto que exigem processamento de linguagem de alta qualidade sem recursos computacionais excessivos

Pesquisa e Análise: Adequado para pesquisa acadêmica e científica que requer capacidades avançadas de raciocínio e processamento de conhecimento

Vantagens

Requisitos computacionais significativamente reduzidos em comparação com modelos maiores

Desempenho comparável a modelos muito maiores

Custo-efetivo para implantação em produção

Desvantagens

Ainda requer recursos computacionais substanciais (embora menos que o modelo 405B)

Algumas lacunas de desempenho em comparação com o Llama 3.1 405B em tarefas específicas

Como Usar o Meta Llama 3.3 70B

Obter Acesso: Preencha o formulário de solicitação de acesso no HuggingFace para obter acesso ao repositório restrito do Llama 3.3 70B. Gere um token READ do HuggingFace que é gratuito para criar.

Instalar Dependências: Instale as dependências necessárias, incluindo a biblioteca transformers e o PyTorch

Carregar o Modelo: Importe e carregue o modelo usando o seguinte código:

import transformers

import torch

model_id = 'meta-llama/Llama-3.3-70B-Instruct'

pipeline = transformers.pipeline('text-generation', model=model_id, model_kwargs={'torch_dtype': torch.bfloat16}, device_map='auto')

Formatar Mensagens de Entrada: Estruture suas mensagens de entrada como uma lista de dicionários com as chaves 'role' e 'content'. Por exemplo:

messages = [

{'role': 'system', 'content': 'Você é um assistente útil'},

{'role': 'user', 'content': 'Sua pergunta aqui'}

]

Gerar Saída: Gere texto passando mensagens para o pipeline:

outputs = pipeline(messages, max_new_tokens=256)

print(outputs[0]['generated_text'])

Requisitos de Hardware: Certifique-se de ter memória GPU adequada. O modelo requer significativamente menos recursos computacionais em comparação com o Llama 3.1 405B, enquanto oferece desempenho semelhante.

Seguir Política de Uso: Cumpra a Política de Uso Aceitável da Meta disponível em https://www.llama.com/llama3_3/use-policy e assegure que o uso esteja em conformidade com as leis e regulamentos aplicáveis

Perguntas Frequentes do Meta Llama 3.3 70B

Meta Llama 3.3 70B é um modelo de linguagem grande (LLM) gerativo pré-treinado e ajustado por instruções criado pela Meta AI. É um modelo multilíngue que pode processar e gerar texto.

Postagens Oficiais

Carregando...Artigos Relacionados

Artigos Populares

Tutorial Atoms 2026: Crie um Painel SaaS Completo em 20 Minutos (AIPURE Prático)

Mar 2, 2026

Ferramentas de IA Mais Populares de 2025 | Atualização de 2026 da AIPURE

Feb 10, 2026

Moltbook AI: A Primeira Rede Social de Agentes de IA Pura de 2026

Feb 5, 2026

ThumbnailCreator: A Ferramenta de IA Que Resolve o Estresse das Suas Miniaturas do YouTube (2026)

Jan 16, 2026

Análises do Site Meta Llama 3.3 70B

Tráfego e Classificações do Meta Llama 3.3 70B

0

Visitas Mensais

-

Classificação Global

-

Classificação por Categoria

Tendências de Tráfego: Jul 2024-Jun 2025

Insights dos Usuários do Meta Llama 3.3 70B

-

Duração Média da Visita

0

Páginas por Visita

0%

Taxa de Rejeição dos Usuários

Principais Regiões do Meta Llama 3.3 70B

Others: 100%