Trainkore

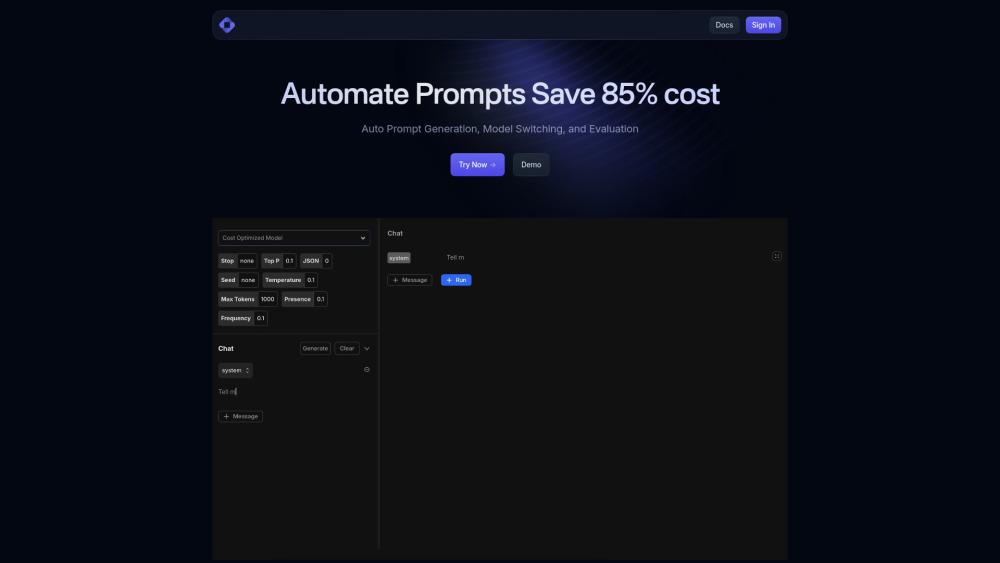

Trainkoreは、自動プロンプトエンジニアリングプラットフォームであり、モデル切り替え、評価、および複数のLLMプロバイダー間での最適化を可能にし、最大85%のコスト削減を実現します

https://trainkore.com/?utm_source=aipure

製品情報

更新日:2024年11月09日

Trainkoreとは

Trainkoreは、大規模言語モデル(LLM)とのインタラクションを管理および最適化するための統一プラットフォームです。これは、組織が自動プロンプト生成、モデルルーティング、およびパフォーマンス監視を通じて複数のAIモデルを扱うのを助ける包括的なソリューションとして機能します。このプラットフォームは、プロンプトエンジニアリング、バージョン管理、および人気のあるAIフレームワークとの統合のためのツールを提供することで、AIの実装をより効率的かつコスト効果的にするように設計されています。

Trainkoreの主な機能

Trainkoreは、複数のLLMプロバイダーにわたる自動プロンプト生成、モデル切り替え、および評価機能を提供する統合AIプラットフォームです。プロンプトのバージョン管理、可観測性スイート、パフォーマンス最適化などの機能を提供し、単一のLLMを使用する場合と比較して最大85%のコスト削減を実現すると主張しています。

自動プロンプト生成: さまざまなユースケースや異なるAIモデルに対して最適化されたプロンプトを動的に生成します

モデルルーターと切り替え: OpenAI、Gemini、Coherence、Anthropicを含む複数のLLMプロバイダー間でリクエストをインテリジェントにルーティングし、パフォーマンスとコスト効率を向上させます

包括的な可観測性: AIインタラクションの監視とデバッグのための詳細なログ、メトリック、およびパフォーマンス分析ツールを提供します

プロンプトバージョン管理: プロンプトのバージョン管理を維持し、パフォーマンスデータに基づいて反復的な改善を可能にします

Trainkoreのユースケース

AI開発統合: LangchainやLlamaIndexなどの既存のAIフレームワークとシームレスに統合し、開発ワークフローを強化します

コスト最適化: インテリジェントなモデルルーティングと最適化を通じて、組織がAI運用コストを削減するのを支援します

パフォーマンス監視: 包括的なログ記録と分析を通じて、チームがAIモデルのパフォーマンスを追跡および分析できるようにします

メリット

最適化による大幅なコスト削減

複数のAIプロバイダーとの簡単な統合

包括的な監視および分析機能

デメリット

実験的な機能は完全に安定していない可能性があります

すべての機能を効果的に利用するための学習曲線

Trainkoreの使い方

Trainkoreをインストール: プロジェクトにTrainkoreをインポートして初期化します: import Trainkore from 'trainkore'

インスタンスを作成: 次のコードで新しいTrainkoreインスタンスを初期化します: const trainkore = new Trainkore()

チャットプロンプトを設定: trainkore.chatPrompt.create()を使用して、メッセージとモデルパラメータを持つオブジェクトを作成してチャットプロンプトを設定します

モデルを選択: モデルパラメータ内でOpenAI、Anthropic、Llama2またはカスタムモデルを含む利用可能なモデルから選択します

プロンプトを生成: 自動プロンプト生成機能を使用して、異なるユースケースのために動的にプロンプトを作成します

パフォーマンスを監視: 可観測性スイートにアクセスして、メトリクス、デバッグログ、および入出力パフォーマンスを分析します

バージョン管理: プロンプトのバージョン管理システムを使用して、組織全体でプロンプトを管理および反復します

結果を評価: パフォーマンスを評価するために、入力、出力、評価、プロンプト、およびメタデータを含むログをレビューします

Trainkoreのよくある質問

Trainkoreは、オートプロンプト生成、モデル切り替え、および評価機能を提供するプロンプティングおよびRAGプラットフォームです。これは、単一のLLMを使用するよりも高いパフォーマンスと低コストを提供します。